- Ce este interzice coșul CGI?

- Ce înseamnă refuz în txt-ul roboților?

- Cum dezactivez robotul txt?

- Cum citesc un fișier txt pentru roboți?

- Ce este coșul CGI în robotul txt?

- Respectă Google txt-ul roboților?

- Poate Google să acceseze cu crawlere fără roboți txt?

- Este necesar txt robot?

- Ce poate face un hacker cu roboții txt?

- Robotii sunt txt periculoși?

- Puteți împiedica un robot să acceseze cu crawlere un site web?

Ce este interzice coșul CGI?

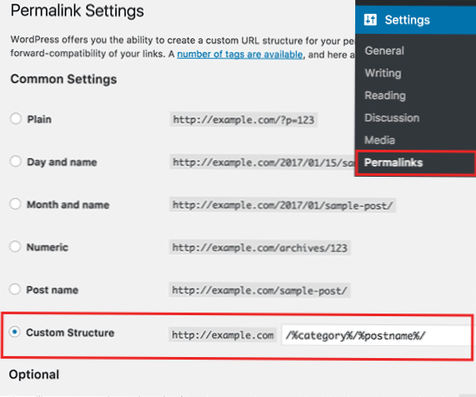

Disallow: / Următoarele indică tuturor roboților (indicați prin comanda wildcard în funcția „User-agent:”) să nu permită indexarea folderului cgi-bin, imagini și descărcări. De asemenea, nu permite administratorului. fișierul php care trebuie indexat, care se află în directorul rădăcină.

Ce înseamnă refuz în txt pentru roboți?

Pe scurt

„Disallow: /” spune robotului că nu ar trebui să viziteze nicio pagină de pe site. Există două considerații importante atunci când utilizați / roboți. txt: roboții vă pot ignora / roboții.

Cum dezactivez robotul txt?

Cele mai bune practici pentru reducerea riscurilor roboților. txt Fișiere

- Înțelegeți ce roboți. ...

- Aveți grijă când utilizați Noindex și roboți. ...

- Utilizați Noindex, Not Disallow, pentru paginile care trebuie să fie private, dar accesibile publicului. ...

- Nu permiteți directoare, pagini nespecifice. ...

- Configurați un Honeypot pentru lista neagră IP.

Cum citesc un fișier txt pentru roboți?

Pentru a accesa conținutul roboților oricărui site. fișier txt, tot ce trebuie să faceți este să tastați „/ robots. txt ”după numele domeniului din browser.

Ce este coșul CGI în robotul txt?

De exemplu: user-agent: FreeFind disallow: / cgi-bin / allow: / cgi-bin / Ultimate.cgi permit: / cgi-bin / forumdisplay.cgi. Acest roboți. fișierul txt împiedică accesarea păianjenului la fiecare adresă cgi-bin, cu excepția Ultimate. cgi și forumdisplay.

Respectă Google txt-ul roboților?

Google a anunțat oficial că GoogleBot nu va mai asculta de Roboți. directiva txt legată de indexare. Editorii care se bazează pe roboți. Directiva txt noindex are până la 1 septembrie 2019 să o elimine și să înceapă să utilizeze o alternativă.

Poate Google să acceseze cu crawlere fără roboți txt?

fișierul txt nu există. Aceasta înseamnă că crawlerele vor presupune, în general, că pot accesa cu crawlere toate adresele URL ale site-ului web. Pentru a bloca accesarea cu crawlere a site-ului, roboții.

Este necesar txt robot?

Majoritatea site-urilor web nu au nevoie de roboți. fișier txt. Acest lucru se datorează faptului că Google poate găsi și indexa toate paginile importante de pe site-ul dvs. Și NU vor indexa automat paginile care nu sunt importante sau nu vor copia versiunile altor pagini.

Ce poate face un hacker cu roboții txt?

fișierele txt pot oferi atacatorilor informații valoroase despre potențiale ținte, oferindu-le indicii despre directoarele pe care proprietarii lor încearcă să le protejeze. Roboți. fișierele txt indică motoarelor de căutare ce directoare de pe un server web pot și nu pot citi.

Roboții sunt txt periculoși?

Prezența roboților. txt nu prezintă în sine niciun fel de vulnerabilitate de securitate. Cu toate acestea, este adesea folosit pentru a identifica zone restricționate sau private ale conținutului unui site.

Puteți împiedica un robot să acceseze cu crawlere un site web?

Primul pas pentru oprirea sau gestionarea traficului bot către un site web este includerea unui robot. fișier txt. Acesta este un fișier care oferă instrucțiuni pentru roboții care accesează cu crawlere pagina și poate fi configurat pentru a împiedica roboții să viziteze sau să interacționeze complet cu o pagină web.

Usbforwindows

Usbforwindows

![Nu permiteți / cgi-bin sau nu? [închis]](https://usbforwindows.com/storage/img/images_5/disallow_cgibin_or_not_closed.png)